Штучний інтелект навчився створювати переконливі фейки, які можуть ввести в оману навіть найбільш досвідчених користувачів інтернету.

Поняття “дипфейк” з’явилося не так давно. Про феномен дипфейку вперше було повідомлено в грудні 2017 року в науково-технічному розділі журналу Vice, і згодом активно поширено в інших ЗМІ.

Це фото, відео чи аудіо, що створюється за допомогою алгоритмів машинного навчання, і повністю відтворює голос, зображення чи відеозображення людини. Фактично створює фейковий матеріал.

Про дезінформацію, яка створюється за допомогою штучного інтелекту для підриву довіри до авторитетних джерел, маніпулювання громадською думкою та суспільними настроями, втручання у виборчі процеси іт.п.

Наприклад 2 березня 2022 року Центр стратегічних комунікацій та інформаційної безпеки у Facebook повідомив, що росія готує нову інформаційну провокацію – на українських телеканалах може з’явитися фейкове відео із президентом України Володимиром Зеленським, який робить заяву про капітуляцію. І що це відео можна зробити за технологією дипфейка.

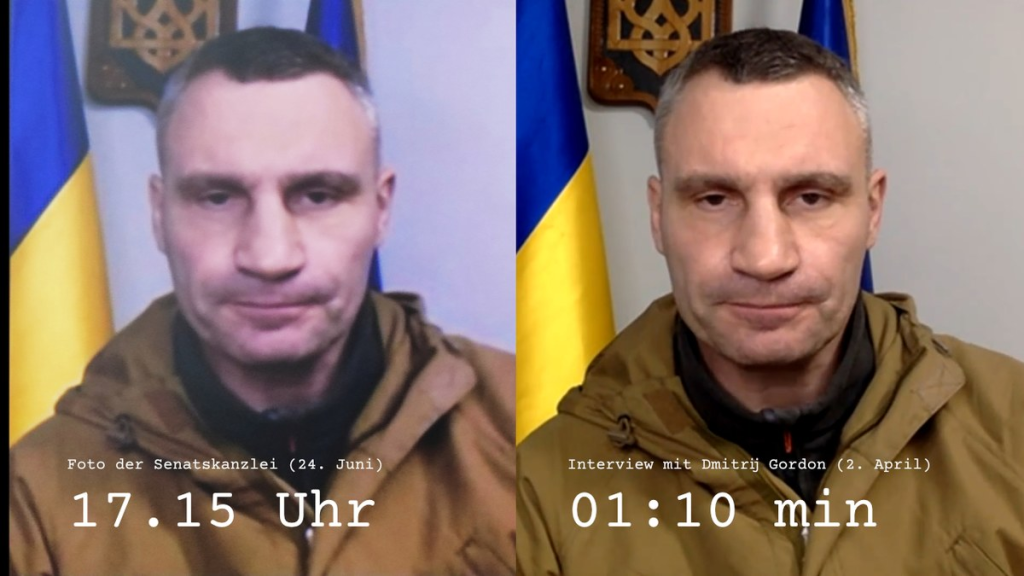

Показовою є ситуація, коли мери Берліна, Відня, Мадрида, Будапешта та Варшави провели дзвінок зі згенерованою версією Віталія Кличка. І зараз вже існує багато подібних прикладів введення в оману публічних осіб. Ці інциденти викликають серйозні питання щодо безпеки та можливості використання ШІ з маніпулятивною метою.

Крім підробки зображень, інструменти штучного інтелекту можуть досить професійно проводити маніпуляції зі звуком. Існують технології, які можуть імітувати голос конкретної особи, створюючи аудіозаписи, які звучать, наче вони були сказані реальною людиною.

Голосові дипфейки активно застосовують шахраї в Україні.

Якщо раніше вони зламували сторінки у соцмережах і від імені власника розсилали повідомлення його друзям з проханням терміново переказати гроші на картку чи за номером телефону, то зараз зловмисники застосовують штучний інтелект для створення голосових повідомлень.

За основу для генерації голосу беруть старі голосові повідомлення, які шахраї знаходять у листуваннях і чатах власника облікового запису, який зламали, і розсилають запис списку контактів.

В інший спосіб – телефонують з невідомих номерів на ваш номер телефону, записують голос, генерують запис і телефонують родичам чи друзям, розповідаючи від імені власника голосу, що потрапив у біду і терміново потрібні гроші.

У результаті виходить досить правдоподібний запис голосом жертви. Почувши знайомий голос, друзі та знайомі найчастіше не просять додаткових підтверджень і переказують гроші. При цьому якісь неприродні обриви мови чи інші перешкоди легко пояснюються: записано “на ходу”, на вулиці або в галасливому приміщенні.

Як розпізнати штучний інтелект?

Про те, що голос був згенерований ШІ свідчить:

Монотонність: ШІ-голоси можуть звучати монотонно або без емоцій. Нестандартна інтонація: іноді ШІ може неправильно ставити наголос у словах або робити паузи в невластивих місцях.

Для перевірки, чи не був голос згенерованим, можна використати Descript’s Overdub.

Що свідчить про “штучність” відео:

Невідповідності в анімації: обличчя або рухи можуть виглядати дещо незвично або неприродно, розсинхронізовано.

Також на відео можуть з’являтися дивні предмети на фоні.

Щоб перевірити, чи було відео згенероване ШІ, можна використати Deepware Scanner.

Також для перевірки контенту можна використати Truly Media – платформа, що містить функції на основі ШІ для перевірки цифрового контенту та виявлення дезінформації.

А від від шахраїв, які по телефону голосом ваших близьких вимагають гроші, можна захиститися простим способом: домовтеся з рідними про слово-пароль, і не піддавайтесь паніці.

І коли вам приходить у соцмережах повідомлення від друзів з проханням переказу коштів – одразу телефонуйте їм особисто і переконайтеся чи надсилали вони насправді це повідомлення.

Ці приклади використання ШІ ще раз підкреслюють важливість уміти вирізняти неправдиву інформацію та перевіряти джерела інформації.

Використане джерело: https://cedem.org.ua/analytics/dezinformatsiya-shtuchnyi-intelekt/